如今,人工智能技术的迅猛发展给各个领域都带来了前所未有的变革和进步。其中当属2023年上半年的“顶流选手”——生成式AI和ChatGPT了。

ChatGPT的火爆出圈,让人们看到了AI惊艳表现的光彩一面,但同时黑暗的一面也正在暗自发力,野蛮生长。

AI技术不仅可用于维护网络安全,还可能为有心之人用以AI网络攻击。AI网络攻击引发了人们对隐私、安全和伦理问题的日益关注。AI攻击不仅仅是黑客利用AI技术进行犯罪活动,还包括其他潜在的威胁,如误导性信息、社会工程等。

下面我们来盘点一下,目前最火热的十大AI新型网络攻击方式。

AI投毒攻击

在加速传统数据安全问题的同时,人工智能大规模的运用使得过度采集数据安全问题进一步加剧,甚至产生“数据投毒”等新型数据安全问题。

一般来说,AI投毒指的是攻击者通过在训练数据中加入精心构造的异常数据,破坏原有的训练数据概率分布,导致模型在某些条件下产生分类或聚类错误,以破坏其训练数据集和准确性。

其中,最常见的投毒形式是后门投毒,即使极少一部分训练数据受到影响。在很长时间里,AI模型仍然可以继续给出高度准确的结果,直到它在接触特定的触发器时被“激活”而功能失灵。

适应场景

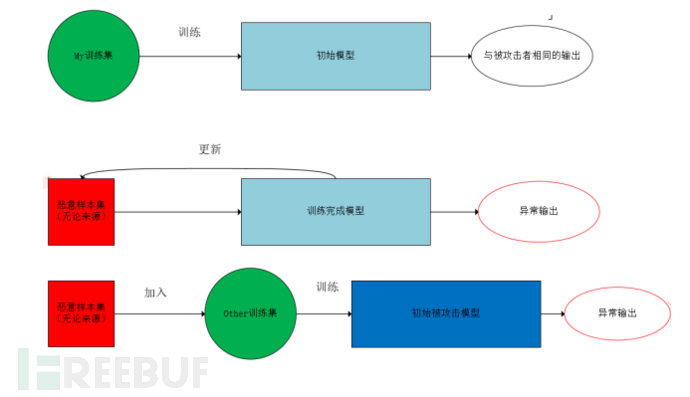

由于数据投毒攻击需要攻击者接触训练数据,通常针对在线学习场景或者需要定期重新训练进行模型更新的系统,这类攻击比较有效,典型场景如推荐系统、自适应生物识别系统、垃圾邮件检测系统等数据投毒攻击流程可以分为三个阶段:

1.根据被攻击模型的输出特征,选择替代的训练集,训练在同样的输入下,具有相同输出的模型。例如对猫狗类别的分类。

2.初始化恶意样本集(无论来源),使用梯度更新(根据需要构建损失函数,例如梯度上升策略)恶意样本,直至达到理想效果。

3.将恶意样本集投入被攻击模型的训练集

“AI模型投毒”会严重威胁到AI应用的完整性和安全性。因此,大型语言模型(LLM)需要接受风险和安全研究人员的严格审查,以探索反馈循环和AI偏见等问题如何使AI输出不可靠。

AI生成恶意软件

在网络安全领域,威胁行为者手中的人工智能的潜在威胁不断敲响警钟。特别是如今利用AI工具创建恶意软件已经成为现实。

研究人员发现,利用生成式AI可以帮助黑客制作恶意软件,并快速发现目标系统中的漏洞,从而加速和扩大攻击规模,甚至比他们使用其他自动化技术所做的还要多。

这也是SANS列举的“2023年最危险的5大网络攻击”中的另一大威胁。在RSAC 2023大会上,SANS漏洞研究人员Steven Sims展示了即使是非专业性的犯罪分子也开始尝试利用ChatGPT生成勒索软件代码,并已经在特定代码段中发现了由ChatGPT自动生成的零日漏洞。

AI数据隐私攻击

在AI应用中,数据隐私和信息安全是首要关注的问题之一。随着大规模数据的收集和存储,个人信息的泄露和黑客攻击的风险也日益增加。数据偏见和算法不公平性可能导致不公正的决策和影响,因此AI算法中的偏见和歧视问题引发了广泛关注。

同时,社交工程和欺诈行为也成为AI应用中的挑战,虚假信息和网络欺诈的增加对社会产生了负面影响。

如果AI模型没有建立足够的隐私措施,攻击者就有可能破坏用于训练这些模型数据的机密性。那么对于个人来说,了解企业如何使用人工智能及其对数据的影响将变得非常重要。同时,攻击者可能还会试图使用恶意软件窃取包含信用卡号码或社会安全号码等个人信息的敏感数据集。隐私风险可能发生在数据生命周期的任何阶段,因此为所有利益相关者制定统一的隐私安全策略非常重要。

武器化模型

武器化模型指的是将人工智能模型或机器学习模型应用于恶意目的或攻击性行为的过程。通常情况下,这种行为是非法且具有破坏性的,旨在侵犯隐私、破坏系统、欺骗用户或其他恶意活动。

武器化模型可以被用于各种攻击场景,如网络攻击、隐私侵犯、社交工程等。

在钓鱼攻击中,可使用自然语言处理模型生成欺骗性的电子邮件或社交媒体消息,以诱骗用户提供个人信息或执行恶意操作。

在使用机器学习模型欺诈对抗其他系统的检测机制,例如在金融交易中规避反欺诈系统。以及在使用机器学习模型对恶意软件进行分类和识别,以侵入系统、窃取信息或造成损害。

此外,此种方式还多用于自动化网络攻击,比如使用机器学习和自适应算法自动查找和利用系统或应用程序的漏洞来进行攻击,如自动化漏洞扫描和利用。

武器化模型还常用于假新闻和虚假信息传播,通过利用自然语言处理模型生成虚假的新闻文章、社交媒体帖子或评论,以操纵舆论或引发混乱。

武器化模型的存在引发了对人工智能和机器学习技术合理使用的关注。为了应对这种威胁,研究人员和业界应从加强安全性分析、加强监管控制和提高用户意识等方面入手,以降低武器化模型的风险和滥用。

海绵攻击

2023年RSAC会议有一个专家小组讨论了CISO将在未来几年面对的即将到来的AI风险和弹性问题。讨论最引人瞩目的一个话题是一种新兴攻击——海绵攻击。

在海绵攻击中,攻击者通过针对海绵结构的弱点来破坏其安全性。攻击的目标是从给定的输入中生成具有特定性质的输出。攻击者通过选择恰当的输入数据和进行特定的修改来实现这一目标,以及通过观察输出数据的反馈信息来指导修改进程。

在这种攻击类型中,对手可通过特制输入来消耗模型的硬件资源,从而对AI模型进行拒绝服务攻击。

CalypsoAI的首席执行官Neil Serebryany称,该攻击试图让神经网络使用更多的计算,以达到可能超过系统可用计算资源的程度,并导致系统崩溃。

AI大模型窃取攻击

AI大模型窃取攻击是一种针对人工智能领域的安全威胁,攻击者试图通过获取训练好的大型AI模型的权重和参数来获取模型的知识和能力,而不必从头开始训练自己的模型。

这种攻击主要基于两种主要方式进行:

- 模型抽取攻击:攻击者可以通过访问目标模型的接口或者黑盒攻击的方式,将一些输入数据提供给模型,并收集模型的输出结果。通过收集大量的输入-输出对,可以逐渐恢复出模型的结构、权重和参数信息,最终获得与原模型相似的模型。

- 模型复制攻击:攻击者可以获取到目标模型的训练数据集或者中间结果,然后使用这些数据重新训练一个与原模型相似的模型。这种攻击方式通常需要大量的计算资源和时间,但可以在一定程度上复制出原有模型的功能和性能。

攻击者从AI技术的应用部署中窃取的不仅仅是数据,还可以通过各种类型的攻击手段破解AI模型的运行原理。AI大模型窃取攻击可以让攻击者获得模型的知识和能力,包括模型所学习到的数据特征和模式。这可能造成原模型的商业机密的泄露,也可能导致在竞争中失去技术优势。

此外,如果攻击者能够获取到一个公司或组织的核心AI模型,他们可以利用此模型在竞争市场中获得不公平的优势,或者滥用模型造成恶意行为从而导致该组织竞争优势被削弱。

为了防止AI大模型窃取攻击,开发人员和研究人员可以采取一些安全措施,包括但不限于加密训练数据和模型权重、限制访问模型接口、使用模型水印技术等。此外,研究者还在探索更为安全的AI模型设计和训练方法,以降低模型窃取的风险。

AI技术的研究与创新需要高度的团队协作和迭代开发,因此会涉及大量的共享,包括数据共享和模型共享,这可能会给AI供应链带来重大风险。研究人员最新发现了一种AI攻击的新模式,攻击者首先劫持了公共代码库上的合法AI模型,再将恶意代码嵌入到这些预训练的AI模型中,对其进行恶意制作,一旦用户重新加载了这些被修改的AI模型,攻击者就可以实施勒索攻击等非法活动。

提示注入攻击:

提示注入(Prompt injection,Pi)攻击是AIGC大语言模型引发内容安全、数据安全及其他风险的重要诱因之一。

提示注入是一种新型漏洞,它会影响某些AI/ML模型。本质上是通过训练听从人类指令的机器学习模型,来遵循恶意用户提供的指令,从而突破模型本身实施的内容生产规则限制,也就是劫持模型输出的过程。

当开发人员将ChatGPT和其他大型语言模型(LLM)整合到他们的应用程序中时,这些恶意的提示就会被AI模型处理,并触发一些不安全的行为动作,比如向网站发布欺诈内容,或者制作可能包含非法的或煽动性信息的电子邮件。

逃逸攻击

逃逸攻击(Evasion attack)是目前最典型的对抗性AI攻击之一。攻击者试图从受限的环境中逃离,获得更高的权限或更广泛的访问权限,从而获取敏感信息或执行未经授权的操作。

攻击者为实施逃逸攻击而特意构造的样本通常被称为“对抗样本。只要一个AI模型在判别机制方面存在不足,攻击者就有可能构造对抗样本用以欺骗AI模型。

研究者一直试图在计算机上模仿人类视觉功能,但由于人类视觉机理过于复杂,两个系统在判别物体时依赖的规则存在一定差异。

这种逃逸攻击可以发生在各种系统和应用程序中,包括操作系统、虚拟化平台、容器、浏览器和移动设备等。攻击者利用系统中的漏洞、错误配置或缺陷的控制机制,通过注入恶意代码、提权、绕过安全限制等方式,成功将自己从一个受限环境“逃离”,获取对系统或其他资源的完全控制权限。

逃逸攻击的危害性非常高,因为攻击者取得了更高的权限,可以绕过各种安全机制和访问限制。一旦攻击者逃逸成功,他们可能可以执行恶意操作,如访问敏感数据、篡改系统配置、拦截通信、安装恶意软件等,从而对系统和用户造成严重的损害。

人工智能生成的网络钓鱼和BEC诱饵

人工智能生成的网络钓鱼和BEC(商业电子邮件欺诈)诱饵指的就是利用人工智能技术生成的虚假电子邮件、信息或其他通信形式,然后伪装成信誉良好的机构、公司、服务提供商或个人,诱使用户相信其真实性,并通过点击链接、下载附件、提供敏感信息、填写表单等方式欺骗员工来获取机密业务信息、敏感财务数据、进行非法转账等行为。

由于冒充者使用了高度逼真的欺骗手法,使得员工很难发觉欺骗,并误以为这些请求是合法和合理的。

人工智能技术的应用使得网络钓鱼和BEC诱饵的攻击更具迷惑性和隐蔽性,使用户更难辨别真伪。

这种由AI生成的网络钓鱼和BEC诱饵往往具备以下“优势”:

- 无语法错误:生成式人工智能技术生成的邮件一般没有语法错误,看起来像是合法的,减少了被标记为垃圾邮件的可能性。

- 降低准入门槛:使用生成式人工智能技术降低了发起复杂BEC攻击的准入门槛。即使攻击者能力不足也可以使用生成式人工智能技术生成垃圾邮件,并发起攻击。

针对此攻击方式,企业需加强员工教育、实施有效的安全控制和监测,以及建立内部报告机制是防范BEC诱饵攻击的关键措施。

Deepfake 深度伪造骗局

如今,ChatGPT已经将deepfake(深度伪造)攻击从理论变成了现实威胁。

如果不法分子借助这种深度伪造技术,对企业或个人进行攻击,不仅会威胁国家安全和公共安全,还可能借此散布虚假视频,激化社会矛盾,煽动暴力和恐怖行动,也可能用于干扰竞争国家的情报机构,甚至因此设定限制其行动范围的条件。

同时,该技术也让视频换脸技术门槛降低,别有用心之人利用深度伪造技术可以轻易绑架或盗用他人身份,甚至可以说深度伪造技术有可能成为实施色情报复、商业诋毁、敲诈勒索、网络攻击和犯罪等非法行为的新工具。

结语

如今,AI带来的威胁已经是“兵临城下”。随着人工智能的应用范围不断扩大,新型攻击技术正在不断涌现。AI新型攻击给个人、企业和整个社会带来了巨大的风险和危害。

一方面,AI可以成为网络可见性、异常检测和威胁自动化的有力工具。另一方面,AI也可以是黑客闯入系统窃取数据的邪恶力量。

对于网络安全的攻防博弈来说,AI既是“天使”,也是“恶魔”,究竟如何张弛有度地把控AI至关重要。

AI与网络安全本就是两个紧密相关且互相影响的领域。通过使用AI技术,可以提升网络安全水平,保护数据和设备不受攻击或破坏;但同时也要注意AI本身所带来的一些挑战和风险,并采取相应的措施来应对。

AI的发展给我们带来了前所未有的可能性,但也需要人们保持警惕,认识到技术本身的局限性,只有综合运用技术、法律、教育等多种手段,才能够构建一个安全可靠的网络环境。

参考来源:

https://zhuanlan.zhihu.com/p/624208064

https://baijiahao.baidu.com/s?id=1766923606211367922&wfr=spider&for=pc

如需授权、对文章有疑问或需删除稿件,请联系 FreeBuf 客服小蜜蜂(微信:freebee1024)