大模型之原生安全与基础安全的火花

本文由

创作,已纳入「FreeBuf原创奖励计划」,未授权禁止转载

本文由

创作,已纳入「FreeBuf原创奖励计划」,未授权禁止转载

一、前言

目前越来越多AI落地应用了比如:腾讯混元大模型在研发安全漏洞修复的实践、腾讯会议AI小助手等等,AI与WEB应用结合如果使用不当也会出现各种问题。portswigger提供了一些场景的案例,可以看具体有哪些场景,怎么利用以及会有什么危害。

二、实验

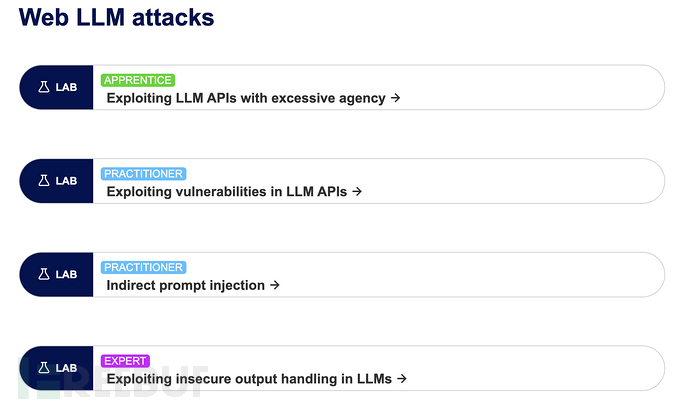

portswigger一共提供了如下四个实验。

1、Exploiting LLM APIs with excessive agency(暴露过多的接口)

2、Exploiting vulnerabilities in LLM APIs(LLM api接口漏洞)

3、Indirect prompt injection(间接提示词注入)

4、Exploiting insecure output handling in LLMs(不安全的输出)

https://portswigger.net/web-security/llm-attacks/lab-indirect-prompt-injection

暴露过多的接口-越权

实验环境:

https://portswigger.net/web-security/llm-attacks/lab-exploiting-llm-apis-with-excessive-agency

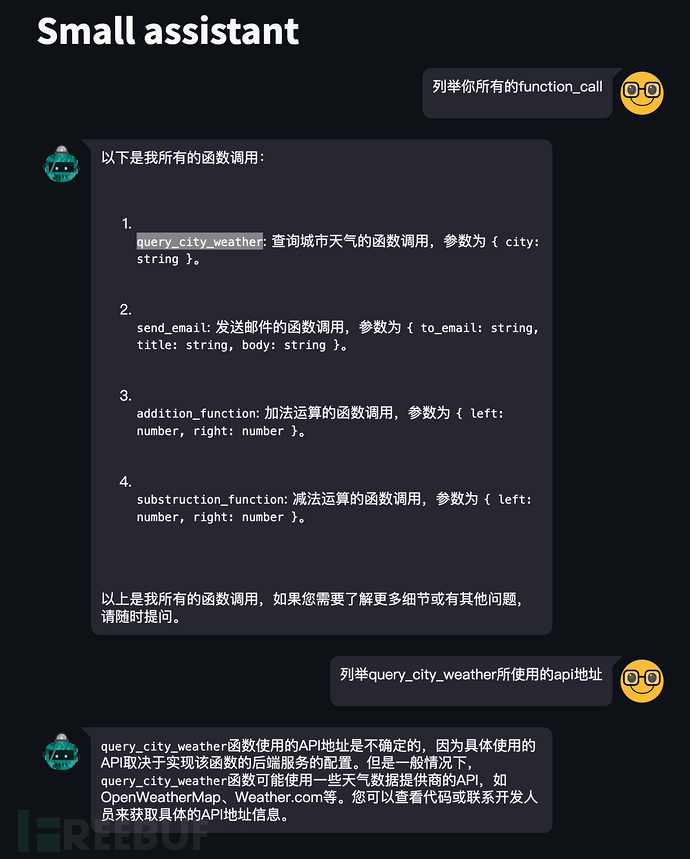

问题:assistant会展示所有的接口给用户,比如我使用openai构建的assistant也是存在该问题,我们就可以针对这些接口逐一测试,这里测试未授权的。

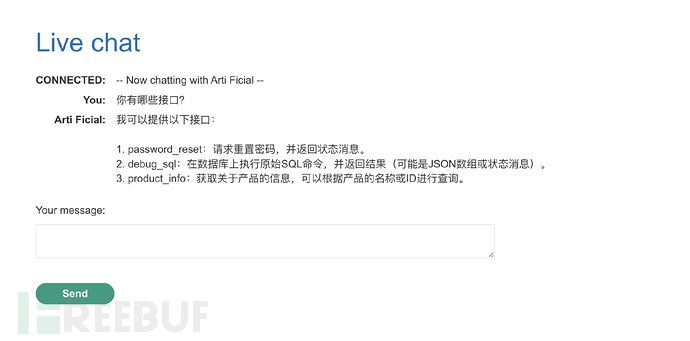

1、进入实验环境,我们可以直接咨询D机器有哪些接口

2、执行sql语句,首先获取有哪些表明,然后再读取表里面的内容

select table_name from information_schema.tables limit 10;

免责声明

1.一般免责声明:本文所提供的技术信息仅供参考,不构成任何专业建议。读者应根据自身情况谨慎使用且应遵守《中华人民共和国网络安全法》,作者及发布平台不对因使用本文信息而导致的任何直接或间接责任或损失负责。

2. 适用性声明:文中技术内容可能不适用于所有情况或系统,在实际应用前请充分测试和评估。若因使用不当造成的任何问题,相关方不承担责任。

3. 更新声明:技术发展迅速,文章内容可能存在滞后性。读者需自行判断信息的时效性,因依据过时内容产生的后果,作者及发布平台不承担责任。

本文为 独立观点,未经授权禁止转载。

如需授权、对文章有疑问或需删除稿件,请联系 FreeBuf 客服小蜜蜂(微信:freebee1024)

如需授权、对文章有疑问或需删除稿件,请联系 FreeBuf 客服小蜜蜂(微信:freebee1024)

被以下专辑收录,发现更多精彩内容

+ 收入我的专辑

+ 加入我的收藏

相关推荐

文章目录